引言

在大數據與實時流處理領域,Apache Kafka已成為構建高吞吐量、低延遲數據管道的核心組件。本文將系統性地介紹Kafka集群的搭建、數據源管理、環境配置、消息存儲機制以及數據處理服務,旨在為構建可靠的數據處理與存儲平臺提供實踐指導。

一、Kafka集群環境搭建

1. 環境準備與規劃

- 硬件要求:建議使用多臺物理機或虛擬機(至少3臺),確保充足的磁盤I/O和內存資源。

- 軟件依賴:安裝Java運行環境(推薦JDK 8或11),并下載Kafka安裝包(如kafka_2.13-3.5.0)。

- 網絡配置:確保集群節點間網絡互通,并規劃好ZooKeeper與Kafka服務的端口(默認分別為2181和9092)。

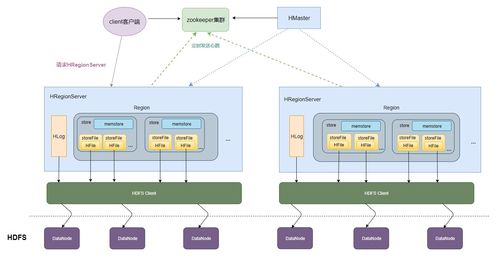

2. ZooKeeper集群部署

Kafka依賴ZooKeeper管理集群元數據(如Broker、Topic、分區信息)。部署步驟包括:

- 在每臺節點解壓ZooKeeper安裝包,配置

zoo.cfg文件,設置dataDir和server列表。 - 啟動所有節點的ZooKeeper服務,并通過

zkServer.sh status驗證集群狀態。

3. Kafka集群配置與啟動

- Broker配置:編輯每臺節點的

server.properties文件,關鍵參數包括: broker.id:唯一標識每個Broker(如0、1、2)。

listeners:設置監聽地址(如PLAINTEXT://hostname:9092)。

log.dirs:指定消息日志存儲目錄。

zookeeper.connect:指向ZooKeeper集群地址(如node1:2181,node2:2181,node3:2181)。

- 啟動集群:依次在各節點執行

bin/kafka-server-start.sh config/server.properties,并通過jps命令檢查進程。

4. 集群驗證

- 創建測試Topic:

bin/kafka-topics.sh --create --topic test --partitions 3 --replication-factor 2 --bootstrap-server node1:9092 - 查看Topic詳情:

bin/kafka-topics.sh --describe --topic test --bootstrap-server node1:9092 - 生產與消費測試消息,確認集群功能正常。

二、數據源管理與接入

1. 數據源類型與連接器

Kafka支持多種數據源接入,包括數據庫、日志文件、消息隊列等。常用工具包括:

- Kafka Connect:提供可擴展的框架,通過Source Connector(如Debezium for MySQL)和Sink Connector(如Elasticsearch Sink)實現數據導入導出。

- 自定義生產者:使用Kafka客戶端API(Java/Python/Go等)編寫程序,將應用數據發送至Kafka Topic。

2. 數據接入最佳實踐

- 序列化格式:推薦使用Avro、Protobuf等高效序列化方案,配合Schema Registry(如Confluent Schema Registry)管理數據模式。

- 容錯處理:配置生產者重試機制(

retries)和冪等性(enable.idempotence=true),避免數據丟失或重復。 - 監控告警:集成Prometheus和Grafana監控生產速率、延遲等指標,確保數據管道健康。

三、消息存儲機制詳解

1. 存儲架構核心概念

- Topic與分區:每個Topic分為多個分區(Partition),實現并行處理與水平擴展。

- 副本機制:每個分區可配置多個副本(Replica),其中一個是Leader負責讀寫,其余Follower用于故障轉移。

- 日志段(Log Segment):分區數據按順序寫入日志文件,分為多個段(如1GB一段),舊段可壓縮或刪除。

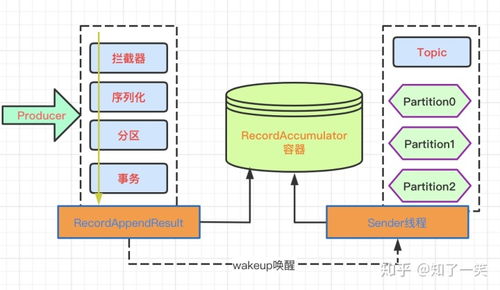

2. 寫入與持久化流程

- 生產者發送:消息按分區策略(如輪詢、Key哈希)發送至對應分區Leader。

- 日志追加:Leader將消息順序追加到分區日志末尾,并同步到所有ISR(In-Sync Replicas)副本。

- 刷盤策略:通過

flush.messages(消息數閾值)或flush.ms(時間閾值)控制數據落盤,平衡性能與持久性。

3. 數據清理與保留策略

- 基于時間:

log.retention.hours(默認168小時)自動刪除舊數據。 - 基于大小:

log.retention.bytes限制Topic總大小。 - 日志壓縮:對Key相同的消息僅保留最新值,適用于狀態變更數據(如數據庫CDC)。

四、數據處理與存儲服務

1. 流處理框架集成

- Kafka Streams:輕量級庫,支持在Kafka集群上直接進行實時數據處理(如過濾、聚合、連接)。

- Apache Flink/Spark Streaming:適用于復雜事件處理或批流一體場景,通過Kafka作為數據源與輸出。

2. 數據存儲與下游服務

- 實時數據湖:通過Sink Connector將數據導入Delta Lake或Apache Iceberg,支持ACID事務查詢。

- OLAP分析:連接ClickHouse、Doris等OLAP數據庫,實現亞秒級多維分析。

- 搜索與監控:同步數據至Elasticsearch或Prometheus,用于日志檢索或指標告警。

3. 運維與監控體系

- 集群健康檢查:使用Kafka內置工具(如

kafka-broker-api-versions.sh)或第三方平臺(如Kafka Manager)。 - 性能調優:根據負載調整

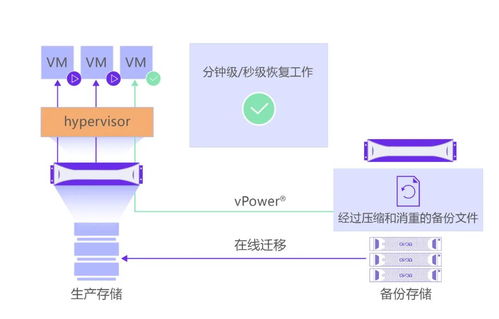

num.io.threads、socket.send.buffer.bytes等網絡與I/O參數。 - 災難恢復:定期備份Topic數據與ZooKeeper元數據,并設計跨機房多集群復制方案。

##

Kafka集群的穩定運行依賴于精細的環境搭建、可靠的數據源管理、高效的消息存儲機制以及靈活的數據處理服務。通過本文所述的步驟與最佳實踐,可構建出支撐高并發實時數據流的企業級平臺,為業務決策與用戶體驗提供堅實的數據基石。隨著Kafka生態的持續演進(如KIP-500取代ZooKeeper),其易用性與擴展性將進一步提升。